大量数据快速导入mysql的方法

请使用 MySQL8.0 以下,否则 MyISAM 引擎不支持分区,如果用 Innodb 引擎,导入速度和建索引速度将大打折扣,我使用的是 MySQL5.7。

下载 mysql shell 工具

mysql shell 下载地址: https://downloads.mysql.com/archives/shell/

修改配置文件

my.ini 配置文件添加以下两行

[mysqld] secure_file_priv='' local_infile=on

同时如果原先已有以下两行,请先注释掉(关闭二进制日志,加快导入速度)

#binlog_format=mixed #log-bin=binlog

建立数据库和表

#建立数据库 CREATE DATABASE kuzi; use kuzi; #建 weibo 表,分 16 个区 CREATE TABLE `weibos` ( `phone` BIGINT(20) DEFAULT NULL,`uid` BIGINT(20) DEFAULT NULL ) ENGINE=MyISAM DEFAULT CHARSET=ASCII PARTITION BY HASH(uid) PARTITIONS 16; #建 qq 表,分 26 个区 CREATE TABLE `qqs` ( `qq` BIGINT(20) DEFAULT NULL,`phone` BIGINT(20) DEFAULT NULL ) ENGINE=MyISAM DEFAULT CHARSET=ASCII PARTITION BY HASH(qq) PARTITIONS 26;

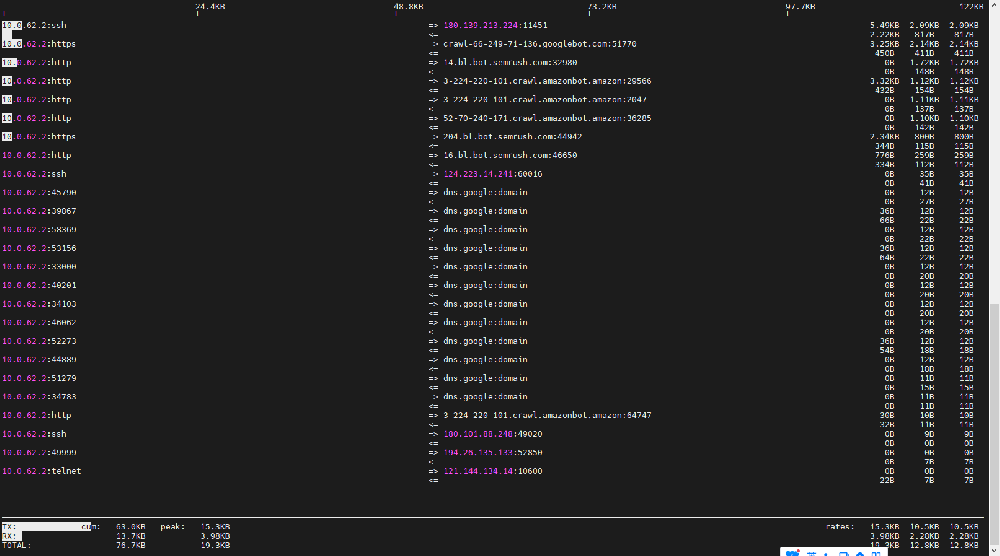

运行 mysqlsh 导入数据

cmd 命令行进入 mysql shell 的 bin 目录运行 mysqlsh.exe,接着输入如下命令

#连接数据库,会提示输入密码

\c root@127.0.0.1:3306

#选择刚刚建的库

\use kuzi

#导入 WB 数据,把 D:/0/weibo_2019_5e.txt 修改成你的文件路径

util.importTable("D:/0/weibo_2019_5e.txt",{"schema":"kuzi","table":"weibos","fieldsTerminatedBy":"\t","showProgress":true,"threads":8,bytesPerChunk: "1G",maxRate: "2G"});

#上面执行完后,再导入 QQ 数据

util.importTable("D:/0/qq_6.9_8e_update.txt",{"schema":"kuzi","table":"qqs","fieldsTerminatedBy":"----","showProgress":true,"threads":8,bytesPerChunk: "1G",maxRate: "2G"});该方法导入应该是最快的了,我笔记本机械硬盘导入两个数据,WB 用了 5 分钟,QQ 用了 7 分钟

建立索引

use kuzi; # WB 的索引 ALTER TABLE `kuzi`.`weibos` ADD INDEX uid_phone (uid,phone); # QQ 的索引 ALTER TABLE `kuzi`.`qqs` ADD INDEX qq_phone (qq,phone);

这一步就比较久了,WB耗时 45 分钟,QQ 耗时 90 分钟